Nell'analisi non standard (NSA) il concetto di limite può ancora essere usato ma è strettamente legato a quello di numero iperreale alla relazione di infinitamente vicino e alla funzione parte standard. Di fatto il calcolo dei limiti dell'analisi classica si riduce alla semplificazione di espressioni iperreali.

Storicamente l'origine del concetto di limite è nei paradossi di Zenone, ma una definizione rigorosa di limite si avrà più di duemila anni dopo alla fine del XIX secolo. Leibniz, Newton, Eulero avevano sviluppato il calcolo infinitesimale non sui limiti ma sui numeri infinitamente grandi e infinitamente piccoli e la NSA recupera questo approccio.

Il concetto di limite nasce da alcuni problemi che l'algebra non è in grado di risolvere. Vediamone alcuni esempi.

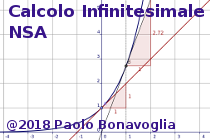

Consideriamo la funzione algebrica fratta:

$$y= \frac{x^2-1}{x-1}$$

Questa funzione è definita per ogni numero reale diverso da 1; per x = 1 la funzione si riduce al quoziente 0/0 che è indeterminato.

È possibile completare la funzione in modo sensato anche per x = 1?

Consideriamo la funzione algebrica fratta:

$$y= \frac{1}{x - 1}$$

Questa funzione è definita per ogni numero reale diverso da 1; per x = 1 la funzione si riduce al quoziente 1/0 che in algebra è considerato impossibile.

Calcolando la funzione per valori prossimi a 1 si nota che avvicinandosi a 1 la funzione assume valori sempre più grandi.

P.es. per x = 0,9 y = -10; per x = 0,99 y = -100, per x = 0,999 y = -1000 ecc.ecc.

P.es. per x = 1,1 y = +10; per x = 1,01 y = +100, per x = 1,001 y = +1000 ecc.ecc.

Viene spontaneo dire che la funzione è infinita per x = 1 tende a infinito quando x si avvicina a 1.

È possibile giustificare in modo rigoroso l'uso della parola infinito?

Consideriamo di nuovo la funzione algebrica fratta:

$$y= \frac{1}{x - 1}$$

Ha senso chiedersi quanto vale la funzione quando x vale infinito?

Calcolando la funzione per valori molto grandi la funzione assume valori sempre più vicini a 0.

P.es. per x = 10 y = 1/9 = 0,(1); per x = 100 y = 1/99 = 0,(01), per x = 1000 y = 0,(001) ecc.ecc.

P.es. per x = -10 y = -1/11 = -0,(09); per x = -100 y = -1/101 = -0,(0099), per x = -1000 y = -0,(000999) ecc.ecc.

Viene spontaneo dire che la funzione per x infinito vale 0 o in altri termini tende a 0 quando x tende a infinito.

È possibile giustificare in modo rigoroso l'uso della parola infinito?